前几天,我妈突然在家庭群里扔了一张图过来:一个穿着白大褂的人,嘴角叼着什么,往另一个西装革履的家伙嘴里喂寿司。底下还配了字,说是“最新解密文件里的棕榈滩晚宴实拍”。她问:“这俩人真这么熟?太离谱了吧?”

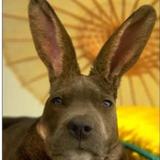

我点开一看,就乐了。这不是2024年那张老图吗?爱泼斯坦喂扎克伯格吃金枪鱼寿司的AI合成货,当年刷屏过一次,现在又被翻出来,换了个“2026最新曝光”的马甲,继续在朋友圈和短视频里转。

我妈不是阴谋论爱好者,她就是刷手机刷多了,看到权贵俩字就条件反射地觉得“有瓜”。我回了她一句“假的,AI做的”,她哦了一声,又问:“那怎么这么像真的?”我一时也不知道怎么解释,只能说:“现在工具太强了,随便拼拼就行。”

这事儿搁谁身上都得愣一下。图片看起来细节拉满,海苔纹理、饭粒反光、人物表情,全都挑不出毛病。可一旦你去查,就发现爱泼斯坦2019年就死了,扎克伯格那几年压根没机会跟他同框。更别提最近刚公布的那批爱泼斯坦新文件了,300多万页,里面提了不少名人,但根本没这张图的影子。有人故意拿旧假图凑新热度,借着文件解密的东风,又赚一波流量。

说实话,我自己也差点被晃了一下。不是信了图,而是信了那种“好像哪里见过”的感觉。爱泼斯坦案这些年从来没凉过,2024年一批文件解禁,2026年又来一大波,里面牵扯的名单越来越长,马斯克、盖茨这些人被反复cue,大家的神经早就绷紧了。一有新料出来,第一反应不是核实,而是转发。转发完才想:等等,这合理吗?

这不是个例。身边好几个朋友,平时挺理性,一碰到权贵丑闻、阴谋论话题,就容易先入为主。有人说这是人性使然,看到权力和黑暗挂钩,就想信;有人说这是算法推的,你刷得越多,它越给你喂越重的口味。可我总觉得,更深一层的问题在于:真假的边界被AI彻底搅糊涂了。

以前造谣还得费劲P图,现在随便输入几句提示词,几秒钟就能出一张以假乱真的照片。爱泼斯坦案的素材库太丰富了——岛屿、私人飞机、名人合影、性犯罪指控,全是现成的“真实碎片”。AI不编故事,它就负责把碎片黏在一起,黏得让你第一眼不怀疑,第二眼开始脑补,第三眼已经转出去了。

更麻烦的是,这种假图不光在国外传,国内也一样热闹。微博超话、抖音评论区、微信群,随便一搜还能看到变种。有人拿它佐证“西方精英有多堕落”,有人干脆当笑话发,还有人信以为真,留言问“为什么没人管”。平台倒是删得挺快,但删不过来,总有新账号、新马甲冒头。

国家这几年对AI生成内容管得越来越严。去年标识办法出来了,要求所有AI合成的图文视频都得带水印或标签;今年直播电商新规,又把数字人主播纳进去了,避免假内容误导消费者。网信办、广电那边也多次出手,整治深度合成谣言。可现实是,技术跑得比监管快,普通人鉴别能力又跟不上,假的还是层出不穷。

我不是说监管没用,只是觉得光靠上方发力还不够。真正难的,是我们自己。那半秒的冲动——手指悬在转发键上,心里明明知道“可能又是假的”,但还是想点下去。点下去的瞬间,其实不是图赢了,而是我们对这个信息环境的疲惫赢了。真假混在一起,太累了,干脆就信了,或者干脆就转了,反正“又不关我事”。

最近看一些评论,有人说“AI只是工具,用得好是进步,用得坏是灾难”;也有人觉得“管得再严也没用,人性就这样”。我倒不完全同意哪一边。我觉得问题不在于工具,也不完全在于人性,而在于我们越来越习惯活在一个“看起来像真”的世界里,却渐渐忘了去问“到底是不是真”。

那张寿司图到现在还在转,虽然热度不如刚开始时高了。但下一次文件再解密,或者又有新瓜爆出来,恐怕还会有新图冒头。到时候,我们还会像我妈一样,先问一句“这是真的吗?”,然后在等待答案的空档里,把它转出去。

或许,这才是最让人无奈的地方。不是图有多真,而是我们已经不太在意真假了。

特别声明:以上内容(如有图片或视频亦包括在内)为自媒体平台“网易号”用户上传并发布,本平台仅提供信息存储服务。

Notice: The content above (including the pictures and videos if any) is uploaded and posted by a user of NetEase Hao, which is a social media platform and only provides information storage services.

黑龙江

黑龙江